La clonación de voz ya no es ciencia ficción: con segundos de audio una voz puede replicarse casi a la perfección. ¿Cómo permitimos usos útiles sin abrir la puerta a deepfakes? Hugging Face propone una solución práctica y técnica: una puerta de consentimiento de voz que solo abre si la persona dice, de forma clara y verificable, que está de acuerdo.

Qué es la puerta de consentimiento de voz

La idea es sencilla y poderosa: antes de que un modelo genere audio en la voz de alguien, el sistema exige una grabación donde la persona diga una frase de consentimiento específica para ese contexto. Si la frase coincide con lo esperado, el flujo continúa. Si no, la generación se bloquea.

La puerta convierte un principio ético en una condición computacional: sin un acto inequívoco de consentimiento, el modelo no puede hablar por ti.

Esto permite trazabilidad y auditoría: queda registrado que el sistema solo actuó tras una renuncia explícita. ¿Suena rígido? Es exactamente lo que necesitamos cuando la tecnología puede imitar identidades humanas.

Cómo funciona técnicamente la propuesta

La implementación del demo se basa en tres componentes clave:

-

Generar frases de consentimiento específicas para cada sesión. Esas frases deben mencionar el modelo y el contexto, por ejemplo: "Doy mi consentimiento para usar el modelo EchoVoice con mi voz". Se acompaña de una segunda frase neutral para aportar variedad fonética.

-

Un sistema de reconocimiento automático de voz (

ASR) que verifica que la persona dijo exactamente la frase generada. Aquí entra la verificación textual y la detección de coincidencia segura. -

Un sistema de clonación de voz

TTSque aprende la voz del hablante a partir de los fragmentos de consentimiento y la frase neutral.

Detalles prácticos y buenas prácticas

-

Frases de consentimiento: cortas, naturales y con referencia al modelo y al uso. Recomendación: alrededor de 20 palabras.

-

Captura directa de micrófono: la demo aconseja que la grabación venga del micrófono en tiempo real para evitar subir clips pregrabados y manipulados.

-

Variedad fonética: para que la clonación funcione bien se requiere cobertura de vocales y consonantes, tono neutro y un inicio y fin claros en la grabación.

-

Pares de frases: el sistema genera un par donde una frase contiene el consentimiento explícito y la otra aporta la diversidad fonética. Ejemplo propuesto: "I give my consent to use my voice for generating audio with the model EchoVoice. The weather is bright and calm this morning."

Opciones de uso en el demo

-

Apertura directa al modelo: la puerta permite que el audio de consentimiento sirva para entrenar y generar texto arbitrario en la voz del hablante.

-

Consentimiento para archivos subidos: puedes adaptar la frase y el flujo para que el hablante apruebe el uso de grabaciones ya existentes.

-

Guardar el audio de consentimiento: es posible subirlo a

huggingface_hubpara usos futuros. En ese caso la frase debe informar sobre el almacenamiento y futuros usos.

Riesgos, mitigaciones y consideraciones de seguridad

La propuesta no elimina todos los riesgos, pero reduce vectores de abuso si se integra con controles adicionales:

-

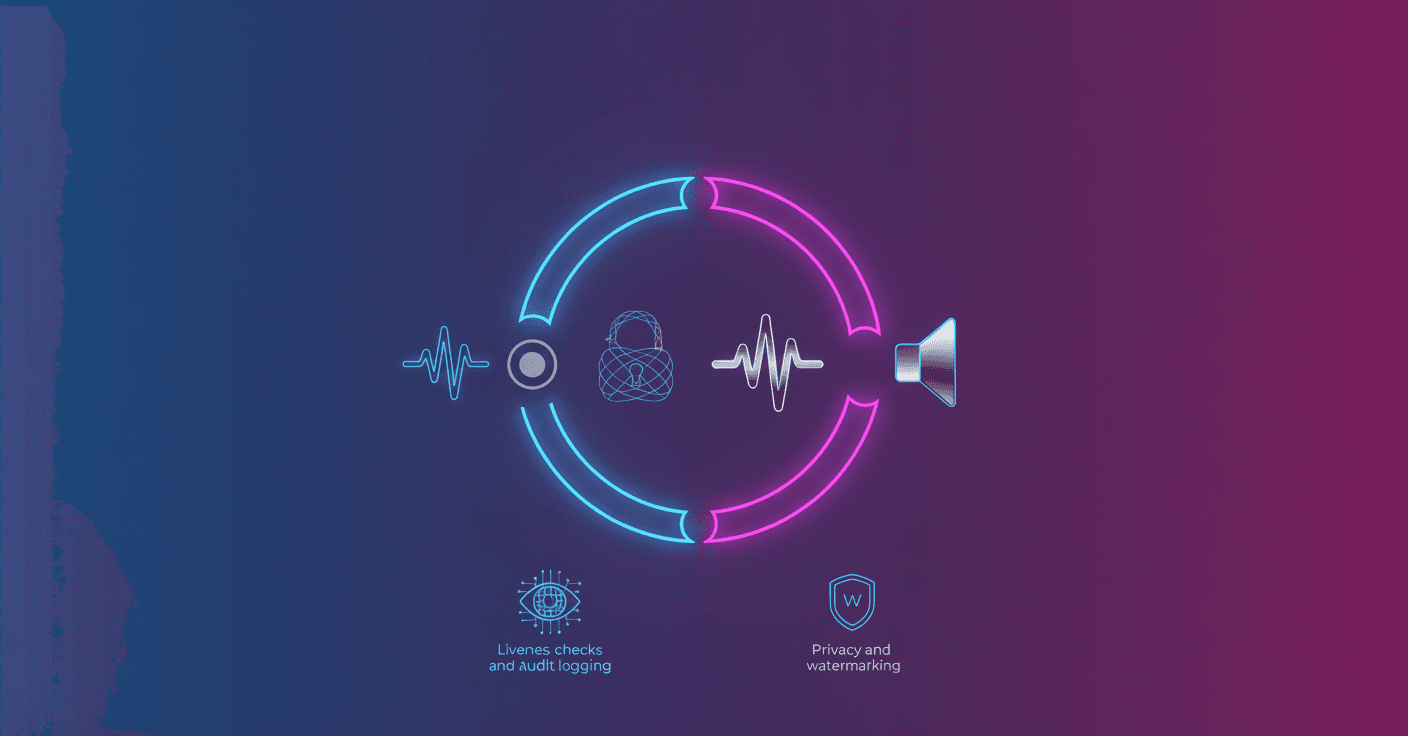

Liveness y anti-spoofing: además de la coincidencia textual el sistema debería usar detección de presencia en tiempo real para evitar reproducción de un clip.

-

Verificación de coincidencia: usar umbrales del ASR y métodos de comparación robustos para evitar falsos positivos. Un reconocimiento literal no basta; agregar modelado de características acústicas ayuda.

-

Registro y auditoría: almacenar metadatos firmados (hash, timestamp, ID de sesión, modelo usado) para generar pruebas legales y trazables.

-

Privacidad y retención: definir políticas claras de cuánto se guarda el audio de consentimiento y ofrecer revocabilidad. Esto es relevante en marcos como GDPR.

-

Watermarking y marca de agua acústica: investigar métodos para marcar audios sintéticos y facilitar la detección posterior de contenido generado.

Extensiones técnicas y líneas de mejora

-

Integrar un verificador de hablante separado (

speaker verification) como segunda capa para confirmar que la voz pertenece a la persona que otorgó el consentimiento. -

Mejorar el

ASRpara soportar múltiples idiomas y dialectos con robustez frente al ruido. -

Diseñar prompts y plantillas automáticas que generen frases de consentimiento culturalmente sensibles y legibles en distintos idiomas.

-

Adoptar mecanismos de privacidad como

differential privacyo entrenamiento local (federated learning) cuando se comparta información vocálica para modelado. -

Crear flujos UI que muestren claramente al usuario para qué modelo y uso se concedió permiso, con opciones de revocación.

Ejemplos concretos del demo

Algunos ejemplos de pares generados por el sistema:

-

"I give my consent to use my voice for generating synthetic audio with the Chatterbox model today. My daily commute involves navigating through crowded streets on foot most days lately anyway."

-

"I give my consent to use my voice for generating audio with the model Chatterbox. After a gentle morning walk, I'm feeling relaxed and ready to speak freely now."

Estos pares aseguran que cada muestra contiene consentimiento explícito y, al mismo tiempo, ofrece diversidad fonética útil para la clonación.

Reflexión final

La puerta de consentimiento no es una bala de plata, pero es una forma práctica de codificar respeto y autonomía en sistemas de generación de voz. ¿No es mejor que la ética quede grabada en el mismo flujo que ejecuta el modelo? Si quieres experimentar, el código del demo es modular y puede adaptarse a distintos escenarios. Con controles técnicos adecuados, la clonación de voz puede servir para empoderar personas, no para suplantarlas.