Imagina que le preguntas a un modelo: "¿El café es bueno para ti?". ¿Qué responde el modelo si no sabe si estás embarazada, si tienes hipertensión o si necesitas una respuesta breve y práctica? Esa falta de contexto hace que muchas evaluaciones de modelos de lenguaje sean injustas o poco útiles.

Qué proponen y cómo funciona

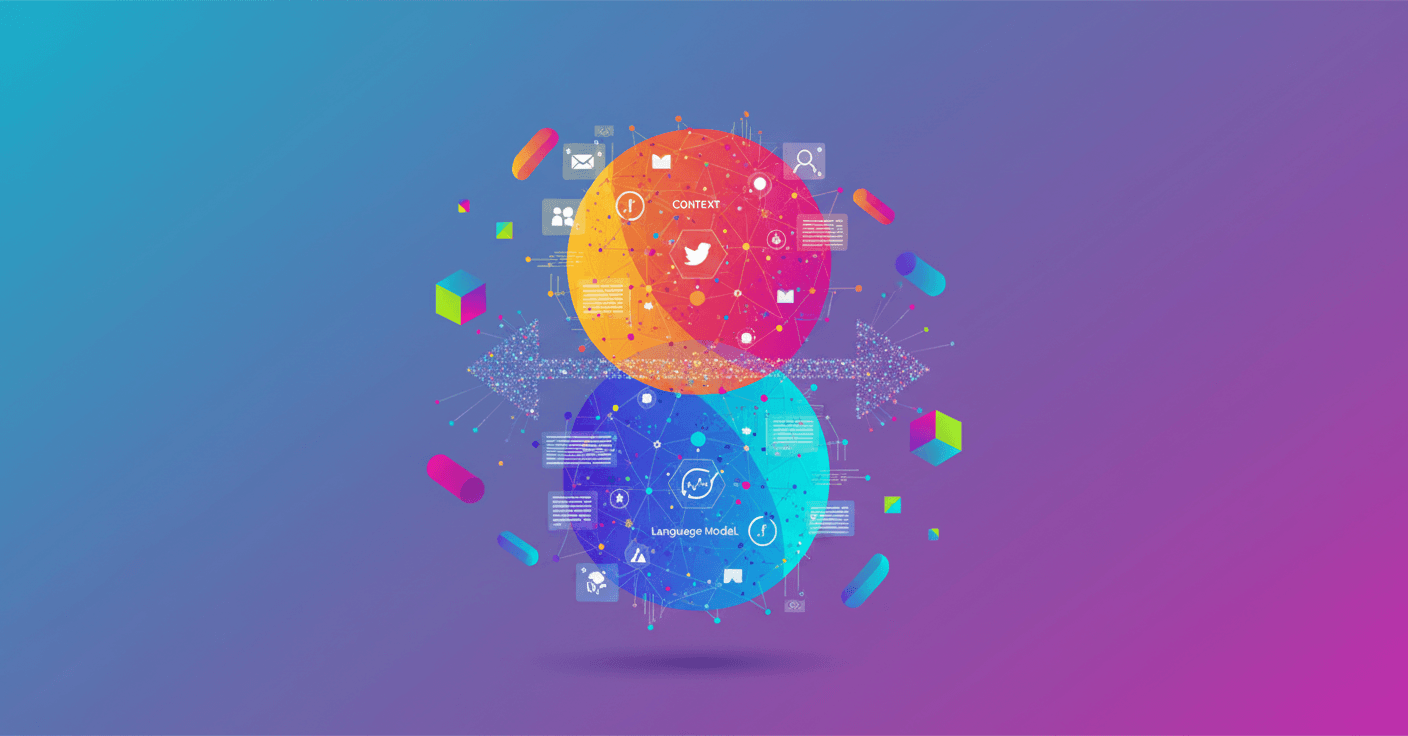

El Allen Institute for AI (Ai2) propone un protocolo llamado Contextualized Evaluations: en lugar de presentar preguntas vagas sin contexto, se generan pares de preguntas y respuestas de seguimiento que simulan la información que un usuario podría aportar en una conversación real. Esto permite que tanto los modelos como los evaluadores trabajen con el mismo escenario y criterios. (allenai.org)

Para generar ese contexto Ai2 usa grandes modelos de lenguaje con prompts sencillos y luego valida las opciones con humanos. Según su estudio, la mayoría de las preguntas generadas fueron consideradas importantes y las respuestas alternativas realistas, completas y diversas. Eso significa que es posible crear contextos plausibles de forma automática y escalable. ()